GG修改器破解版下载地址:https://ghb2023zs.bj.bcebos.com/gg/xgq/ggxgq?GGXGQ

大家好,今天小编为大家分享关于gg修改器更改游戏数据_gg怎么修改游戏数据的内容,赶快来一起来看看吧。

论文收录于CVPR2021

论文题目:

Fast and Accurate Model Scaling

论文地址:

https://arxiv.org/abs/2103.06877

摘要

在这项工作中,我们分析了卷积神经网络的缩放策略;也就是说,扩展一个基本卷积网络的过程,赋予它更大的计算复杂度,从而使其具有更强的表示能力。缩放策略的例子可能包括增加模型宽度、深度、分辨率等,虽然存在各种各样的扩展策略,但它们之间的权衡并不完全清楚,现有的分析通常集中在精度和浮点运算(flops)的相互作用上,然而,正如我们所演示的,不同的伸缩策略对模型参数、激活的影响非常不同,因此实际运行时也非常不同。

在我们的实验中,我们展示了令人惊讶的结果,许多缩放策略产生的网络具有相似的精度,但具有广泛的变化的性质,这导致我们提出了一个简单的快速复合缩放策略,主要鼓励缩放模型宽度,而缩放深度和分辨率在较小程度上,不像目前流行的缩放策略,导致约O(s)的模型激活w.r t增加,虽然比例下降了s倍,但提出的快速复合比例可使性能增加近O(√s),同时获得优异的精度,在现代内存带宽有限的硬件(如gpu)上,更广泛地说,我们希望这项工作为分析各种计算约束下的缩放策略提供一个框架。

1. 简介

在过去几年里,训练和运行卷积神经网络的现代硬件的进步令人印象深刻,高度并行的硬件加速器,如gpu和tpu,允许训练和部署更大、更精确的网络。

有趣的是,这种快速的进步极大地提高了我们优化低计算量模型的能力,特别是,无论是通过人工设计、随机搜索,还是更复杂的神经体系结构搜索策略,训练大量的小模型并选择最佳的模型,无论在准确性还是速度上都已成为可行的方法,在中间计算状态下,高效搜索或高效设计空间仍然可以提供直接优化神经网络的能力。然而,抛开计算资源不谈,必然会存在一个高计算体系,在这个体系中,可能只能训练少数几个模型,甚至可能只有一个模型,这个制度激励着我们的工作。

在高计算模式下,网络缩放—通过扩展一个或多个维度(如深度或宽度)来扩大较低复杂性模型的过程—变得至关重要,在获得精度较高的较大模型方面,缩放已被证明是有效的。然而,现有的模型缩放工作集中在模型精度上,在这项工作中,我们感兴趣的是大型的、准确的模型,它们足够快,可以在实践中部署和使用。

网络缩放的概念在深度学习中自然出现,早期的工作集中在通过增加深度来缩放网络,然而,深度缩放的增益趋于稳定,导致缩放宽度和分辨率的探索,最近,一次缩放多个维度,被称为复合缩放,已被证明能达到极好的精度。

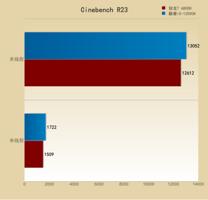

现有的模型缩放的探索通常专注于最大化精度,正如我们将要展示的,两个具有相同精度的比例模型在现代加速器上的运行时间可能非常不同,这将我们引向我们工作中所探索的中心问题:我们能否设计既优化精度又优化模型运行时间的伸缩策略?我们的第一个核心观察是存在多种缩放策略,可以在相同的flops下产生相似的精度模型,在图1(顶部)中,我们展示了存在多种缩放策略,可以产生精度较高的模型,我们将在§6中详述这个结果。

然而,使用两种伸缩策略将模型扩展到固定的目标会导致运行时大不相同,参见图1右下方。为了在更基本的层面上更好地理解这种行为,在§3中,我们开发了一个框架,用于分析各种伸缩策略的复杂性,不仅包括精度,还包括参数,特别是,我们展示了不同的策略以不同的渐进速率相对于失败的激活。例如,当通过缩放宽度将一个模型从f个flops缩放到sf个flops时,激活增加O(√s),而复合缩放则增加近O(s)。图1(左下)显示了一些选择策略的这种渐近行为。

在§4中,我们将展示在具有实际意义的触发器范围内,在现代加速器上,缩放模型的运行时间与激活的相关性比触发器更强,我们强调,这种相关性适用于不同的伸缩策略集,这使我们能够使用激活作为一个代理来预测伸缩模型的运行时间。

基于我们的分析,在§5中,我们引入了一个新的缩放策略家族,由单个参数α参数化,控制了模型宽度相对于其他维度的相对缩放。这让我们可以小心地控制模型激活的渐近速率,我们显示0 <α < 1产生的模型既快又准确,我们将这种缩放策略称为快速复合模型缩放,或者简单地称为快速缩放。

正如我们将在§6中展示的那样,快速缩放使我们能够获得与最先进的模型一样精确但更快的大型模型,作为一个具体的例子,我们应用快速缩放将RegNetY – 4gf模型扩展到16GF (gigaflops),发现它使用的内存更少,速度更快(也更准确),比efficiency entnet – b4[31]模型更少的次数。

2. 相关工作

手工网络设计 自从AlexNet取得令人印象深刻的成功以来,随着硬件加速器的稳步发展,社区已经向更大、更精确的模型推进。增加模型深度导致快速增益,著名的例子包括VGG和Inception,这一趋势随着残差网络的引入而达到顶峰,其次,更广泛的模型被证明不仅有效,而且特别有效,深度和组卷积的使用使容量模型更高,其他值得注意的设计元素导致了更大、更精确的模型,包括 invertedbottleneck、SE和新的非线性。

自动化的网络设计 随着用于训练深度模型的硬件的快速发展,实现网络设计自动化已经变得更加可行,神经体系结构搜索已经成为一个蓬勃发展的研究领域,并导致了高效的模型,特别是在低计算领域。在训练较大的模型时,模型搜索的计算成本很高,这导致了开发高效搜索算法的兴趣,例如,DARTS提出了一种可微搜索策略,不需要训练多个独立的模型来优化模型结构,然而,在实践中,搜索在低或中等计算系统中是最有效的。

设计空间设计 尽管模型搜索是有效的,但该范式也有其局限性,搜索的结果是一个调优到特定设置的单一模型实例(例如,数据集或触发器机制),Radosavovic等人最近引入了设计设计空间的思想,设计了一个由简单、易于调整的模型组成的低维设计空间,给定一个新的数据集或计算模式,可以通过调整少量参数从这个设计空间中选择一个模型,允许高效的随机搜索,这允许在相当高的计算系统中直接优化模型,我们在实验中利用了这些高效的设计空间。

网络扩展 无论采用何种模型设计策略,都会存在一些计算模式,在这种模式下,训练和比较大量的模型是不可行的,因此,模型缩放变得至关重要,常用的缩放策略包括缩放深度、缩放宽度和缩放分辨率,最近引入的复合缩放策略可以同时缩放所有三个维度,实现了极佳的精度与失败的权衡,并作为我们工作的核心基线。

会更大 扩展到海量数据集和计算机制有很大的兴趣,此外,最近在无监督学习方面取得的进展可能创造出使用几乎无限的数据进行训练的潜力,这些努力激励着我们的工作:我们的目标是使模型的规模达到新研究所需的规模。

3.缩放模型的复杂度

在本节中,我们提出了一个分析各种网络扩展策略复杂性的一般框架,虽然该框架简单直观,但它在理解和扩展模型缩放方面被证明是强大的。

3.1. 复杂性度量

我们考虑的模型的三个最相关的属性是它们的flops (f)、参数(p)和激活(a),按照通常的做法,我们用flops表示乘法加法,用参数表示模型中自由变量的数量,我们将激活定义为卷积(conv)层的输出张量中元素的数量。

Flops和参数是常用的神经网络复杂度度量方法,然而,我们注意到卷积的参数与输入分辨率无关,因此不能完全反映卷积网络的实际容量或运行时间,因此,考虑到我们研究具有不同输入分辨率的网络,我们报告参数,但我们关注作为主要复杂性度量的flops,激活的报告较少,但正如我们所演示的,在现代内存带宽有限的硬件上,激活在决定网络速度方面起着关键作用,因此,我们仔细分析了缩放和激活之间的相互作用。

3.2. 网络的复杂性

由于conv网络是由许多异构层组成的,我们的复杂性分析集中在conv层上,首先,许多层(如规范化、池化或激活)通常只占模型计算的一小部分,其次,这些层的数量和复杂性倾向于与卷积的数量和大小成正比(例如,每个卷积层之后可能会有一个激活),由于这些原因,分析卷积可以作为模型缩放如何影响整个网络的极好代理。

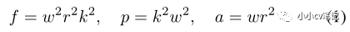

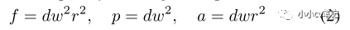

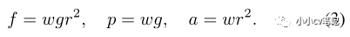

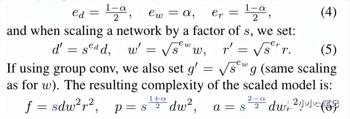

考虑一个k×k conv层,其宽度(通道数)为w,空间分辨率为r,该层接收一个大小为r×r×w的特征图,对于每个大小为k×k×w的r2补丁,网络应用w个大小为wk2的点积,因此,conv层的复杂度由:

由于k没有缩放,让k = 1而不丧失一般性,公共网络由阶段组成,其中每个阶段由d个一致的conv层组成,每个conv层具有相同的w和r。深度为d的阶段的复杂度为:

在随后的分析中,我们将展示不同的伸缩策略如何影响单个阶段的复杂性,为了简单起见,我们对每个网络阶段使用相同的缩放,因此我们的复杂性分析适用于整个网络。

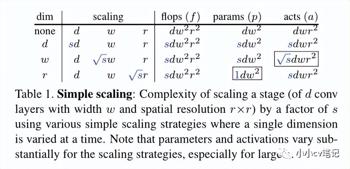

3.3. 简单缩放的复杂度

我们将一个阶段的简单缩放定义为沿着单一维度缩放一个阶段,特别地,我们考虑了宽度(w)、深度(d)和分辨率(r)的缩放。除了缩放维度,我们还定义缩放因子s为缩放增加模型flops的程度,将d增加s, w增加√s, r增加√s,都将flops增加s(为了简单起见,我们忽略量化效应)。

表1显示了沿不同缩放维度按s因子缩放一个阶段的复杂性,虽然在每种情况下产生的 flops 是相同的(设计),但参数和激活是不同的,特别是,当缩放宽度时激活增加了√s,相比之下,缩放分辨率或深度时激活增加了s,这一观察结果将在我们如何设计新的扩展策略中发挥核心作用。

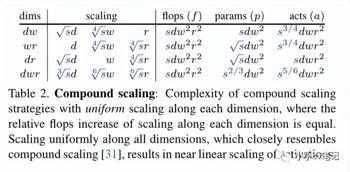

3.4. 复合缩放的复杂性

直观的方法不是沿着单一维度扩展,而是同时沿着多个维度扩展,复合缩放方法已被证明比简单缩放获得更高的精度。

在表2中,我们展示了沿二维或三维扩展的复杂性,在每一种情况下,我们选择的比例都是在每个维度上的比例是一致的,例如,如果按所有维度(dwr)缩放,我们将d缩放3√s, w缩放6√s, r缩放6√s,这样,当每个维度缩放时,flops增加3√s,总共增加3√s3 = s。

有趣的是,经验发现的复合缩放规则沿d、w和r缩放1.2、1.1和1.15,这大致对应于s = 2的均匀复合缩放(3√s≈1.26,6√s≈1.12),因此,为了我们的分析目的,我们使用统一复合缩放作为一个简单的代理,观察到,对于均匀的复合标度,激活率几乎随s线性增加。

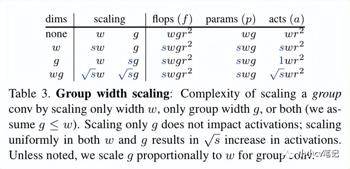

3.5. 组宽度缩放的复杂性

许多性能最好的网络严重依赖于组conv和深度conv,通道宽度为w和组宽度为g的组conv相当于将w个通道分成宽度为g的w/g组,对每个组应用常规的conv,并将结果连接起来,深度conv是g = 1时的特例,因此,其复杂性为:

在表3中,我们展示了缩放组卷积的三种基本策略,我们观察到,要获得与缩放规则卷积相似的缩放行为,通道宽度和组宽度都必须缩放,因此,除非特别说明,我们将g按比例缩放到w,对于使用深度conv (g = 1)的网络,我们不缩放g。

最后,我们注意到,当缩放g时,我们必须确保w能被g整除,为了解决这个问题,我们设置g = w,如果g > w,四舍五入w能被g整除(在这种策略下,w最多变化1/3)。

4. 缩放模型的运行时间

我们的动机是设计缩放策略,以得到快速和准确的模型,在§3中,我们分析了flops、参数和各种缩放策略的激活行为,在本节中,我们将检查这些复杂性度量和模型运行时之间的关系,这将允许我们在§5中设计新的快速伸缩策略。

我们在§3中分析的复杂度指标是如何与现代加速器上的模型运行时间相关的?为了回答这个问题,在图2中,我们报告了大量模型的运行时,这些模型从三个基本模型伸缩而来,作为flops、参数和激活的函数,从这些图中我们可以观察到两点:当通过不同的缩放策略缩放单一模型时,flops和参数对运行时间的预测能力很弱;然而,激活对模型的运行时具有很强的预测性,而不考虑伸缩策略,参见图2了解更多详细信息。

这个简单的结果导致我们使用模型激活作为运行时的代理,具体来说,对于单个模型的缩放版本,无论缩放策略如何,运行时和激活之间的Pearson相关性都是r≥0.99,而与flops和参数的相关性则要低得多,然而,我们警告,激活不能完美地预测异构模型的运行时(r = 0.95),因为模型可能使用不同运行时的操作,例如ReLU和SiLU,此外,一些大型模型的运行时间比激活时预测的要高,这表明这些模型是flop边界。

实现细节 我们报告了在ImageNet上执行一个训练周期的时间,其中包含了约1.2M的训练图像,对于每个模型,我们使用内存中最大的批处理大小,我们注意到推理时间与训练时间高度相关,但是我们报告了epoch时间,因为它很容易解释(推理性能很大程度上取决于用例)。我们使用PyTorch和8个32GB Volta gpu对所有模型进行计时,运行时当然依赖于硬件;然而,我们认为gpu的计时是合理的,有两个原因,首先,硬件加速器(如gpu、tpu等)非常普遍,其次,加速器在计算方面非常高效,但往往受制于内存带宽,而且这一趋势预计将变得更加明显。

5. 快速复合模型缩放

考虑到运行时对激活的强烈依赖性,我们的目标是设计伸缩策略,使模型激活的增加最小化,如表1-3的结果所示,在所有涉及缩放宽度、深度和分辨率的缩放策略中,通过增加通道宽度和组宽度来缩放网络,激活的增加最小,事实上,众所周知,宽频网络是相当有效的,不幸的是,与更深或更高分辨率的模型相比,宽网络可能并不总是能取得最好的结果。

为了解决这个问题,在这项工作中,我们引入了快速复合模型缩放的概念,或者简单地说快速缩放,想法很简单:我们设计和测试缩放策略,主要增加模型宽度,但也在较小程度上增加深度和分辨率。

我们通过引入一系列α参数化的缩放策略来形式化这一点,对于α,我们定义:

使用各种α的缩放策略的实例如表4所示,设置α = 1会导致宽度(w)缩放(最低激活),设置α = 0会导致深度和分辨率(dr)缩放(最高激活),α = 1/3对应均匀复合标度(dwr),我们探索的有趣的新区域是1/3 < α < 1。

特别地,我们将α接近1的缩放策略称为快速缩放,除非特别说明,我们默认使用α = 0.8,我们用dW r表示,接下来,在§6中,我们展示了快速缩放导致良好的速度和准确性。

6. 实验

在本节中,我们将评估我们提出的快速扩展策略的有效性,我们介绍了我们测试的基线网络以及§6.1中的优化设置,在§6.2中,我们评估了现有的缩放策略,然后在§6.3中对快速缩放进行了大量的实验和比较,最后,我们比较了§6.4中的缩放和随机搜索,并比较了§6.5中的大型模型。

6.1. 基线和优化设置

基线网络 在这项工作中,我们评估了三个网络族的伸缩策略:EfficientNet, RegNetY和RegNetZ(描述如下),我们选择这些模型,因为它们是最先进的代表,非常适合我们的缩放实验,此外,在模型缩放工作的背景下引入了EfficientNet,使之成为我们研究的理想对象。

EfficientNet 网络已被证明可以实现良好的失败与准确性的权衡,这些模型使用反向瓶颈、深度conv和SiLU非线性(也称为Swish),一个高效网由七个不同宽度、深度、步幅和内核大小的阶段组成,使用神经结构搜索对原始模型(EfficientNet-B0)在移动状态(400MF)下进行优化,并通过复合缩放缩放到更大的尺寸(B1-B7),注意,高效率网由~ 30个参数指定(输入分辨率,7级,每个级有4个参数,茎和头宽度),考虑到这种高维搜索空间,优化一个高效网只有在低计算量的情况下才可行,必须使用缩放来获得更大的模型。

RegNets 作为神经架构搜索的替代方案,Radosavovic等人引入了设计空间的思想,其中设计空间是模型的参数化总体,使用这种方法,设计了一个由称为RegNets的简单规则网络组成的设计空间,该网络在广泛的块类型和flop都是有效的,对于我们的工作来说,重要的是RegNet模型由少量的参数(~ 6)指定,然后允许使用随机搜索快速选择模型,因此,与高效率网不同,RegNets允许我们比较通过缩放或随机搜索获得的大型模型。

RegNet由一个茎,一个有四个阶段的主体和一个头部组成,每个阶段都由一系列相同的块组成,块类型可以根据模型的不同而变化(我们使用的两种块类型如图3所示),重要的是,RegNet的宽度和深度不是每个阶段独立指定的,而是由一个量化线性函数确定的,该函数有4个参数(d, w0, wa, wm),任何其他块参数(如组宽度或瓶颈比例)在各个阶段保持恒定。

RegNetY RegNetY块(Y)如图3 (ab)所示,Y块类似于组conv的标准残差瓶颈块,此外,它使用挤压-激励(SE)层,我们将瓶颈比率b设置为1(实际上没有瓶颈),RegNetY模型因此完全指定了5个参数:d、w0、wa、wm和g,我们还更改了图像输入分辨率r(使总参数为6)。

RegNetZ 我们提出了一种新的基于反向瓶颈的Z块,Z块与Y块相似,只是它忽略了最后一个非线性并反转了瓶颈(我们在所有实验中都使用b = 1/4),参见图3 (c-d)了解更多细节,使用Z块构建的RegNetZ模型使用与RegNetY模型相同的6个参数完全指定,我们注意到,EfficientNet也使用反向瓶颈,但我们引入RegNetZ,以允许我们比较通过缩放和随机搜索获得的大型模型。

优化设置 我们的目标是实现公平和可重复的结果,然而,我们也致力于达到最先进的结果,这就造成了使用简单而弱的优化设置和产生良好结果但可能难以再现的强大设置之间的紧张关系,为了解决这个问题,我们使用了一种有效平衡这两个目标的训练设置。

我们的设置如下:我们使用动量为0.9的SGD,标签平滑 0.1,mixup α = 0.2 , AutoAugment,随机权重平均(SWA),混合精确训练,对于所有的模型,我们使用5个阶段的逐步预热,我们使用一个批量大小为1024的指数学习率调度(分布在8个32GB gpu上),学习率λ = 2.0,衰减β = 0.02,对于RegNets我们使用2e-5的权重衰减,对于EfficientNets我们使用1e-5的权重衰减,批范数参数不衰减,对于大型模型,我们按比例减少批大小和学习率。

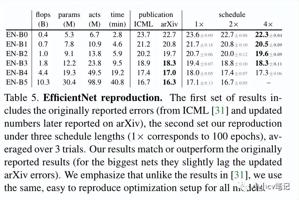

EfficientNet基线 在表5中,我们报告了使用我们的优化设置和EfficientNet结果。我们使用“1×”、“2×”或“4×”时间表报告结果(分别对应100、200和400个epoch),我们的2×时间表取得了具有竞争力的结果,我们的4×时间表在测试的最大模型之外的所有原始报告结果中都优于其他时间表,除特别注明外,我们在接下来的所有实验中都使用2×时间表。

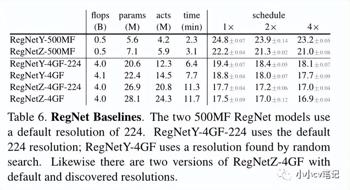

RegNet基线 在表6中,我们报告了基线RegNet模型的结果,我们通过随机搜索获得这些模型,注意,4GF RegNets有两个版本(使用默认分辨率和发现分辨率)。

6.2. 简单和复合缩放

我们现在转向§3.3和§3.4中分别描述的简单和复合缩放的评估,对于这些实验,我们扩展了§6.1中的基线模型。

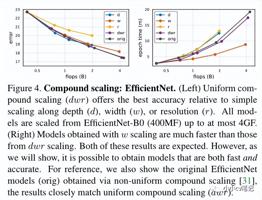

在图4中,我们通过沿着宽度(w)、深度(d)或分辨率(r)的简单缩放,或通过均匀复合缩放(dwr)来评估EfficientNet-B0的精度(左)和运行时(右),正如预期的那样,dwr缩放提供了最好的精度,但结果比w缩放更慢的模型,这意味着在速度和准确性之间需要权衡,但正如我们很快将展示的那样,情况不一定如此。最后,我们测试了沿维度对的统一缩放(参见表2),但dwr缩放被证明是最好的(没有显示)。

我们还比较了均匀复合缩放(dwr)和原始复合缩放规则(orig),后者经验地设置了每维缩放因子,正如我们在§3.4中的分析所预期的那样,dwr缩放在精确度和运行时都接近原始的复合缩放规则,而不需要优化单个缩放因子。

在图5中,我们对RegNetY -500MF 和RegNetZ-500MF 基线重复相同的实验,我们看到了类似的行为,其中dwr伸缩实现了最强的结果,运行时(见附录)表现出非常相似的行为(w伸缩速度更快),注意,如前所述,组宽度g按比例缩放到宽度w。

6.3. 快速缩放

现在,我们对快速扩展策略的有效性进行了实证分析,回想一下,在§5中我们介绍了一系列由α参数化的缩放策略,它在α = 1/3时的均匀复合缩放(dwr)和α = 1时的宽度缩放(w)之间进行插值,当α趋于1时,当我们缩放模型时,模型激活的增加最少,从而产生更快的模型,特别地,我们定义α = 4/5为快速缩放,用dWr表示。

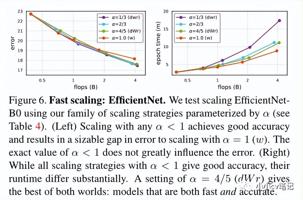

在图6中,我们评估了在α的不同设置下, EfficientNet-B0 缩放的精度(左)和运行时间(右),有趣的是,对于所有α < 1模型的测试值,精确度都非常相似,并且大大高于w缩放(α = 1),特别是对于较大的模型,在运行时方面,dWr缩放几乎和w缩放一样快,而且比dwr缩放快得多,我们强调在内存和速度上的差异渐近增加,因此在更大的尺度上用不同α缩放的模型在运行时间上的差异变得更加明显。

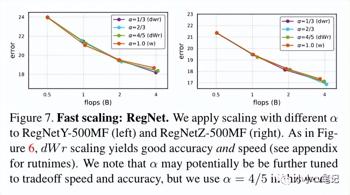

在图7中,我们重复了相同的实验,只是针对RegNet基线,结果相似,dWr缩放(α = 4/5)具有良好的精度和运行时,最后,我们观察到对于RegNets, w尺度比EfficientNet更有效,这可以部分解释为,对于RegNets,我们按宽度w缩放组宽度g(有效率网总是使用g = 1),实际上设置g = 1并仅按w缩放RegNets的性能更差(见附录)。

6.4. 缩放搜索

缩放模型与通过随机搜索获得的模型相比如何?回想一下,RegNet只有6个自由参数,所以直接通过中间flop的随机搜索优化RegNet是可行的(见§6.1)。

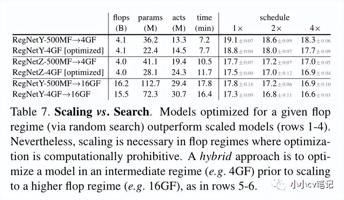

表7比较了三组模型,首先,我们比较第1-2行中通过dWr缩放(表示为RegNetY -500MF→4GF)或搜索(RegNetY 4GF)获得的4GF处的RegNetY,在4×调度下,最佳抽样模型的性能优于缩放模型0.6%,我们对RegNetZ重复这一分析(第3-4行),发现最佳抽样模型比缩放模型表现好0.1%。这些结果表明,缩放一个高精度的模型并不能保证得到一个最优的模型,然而,针对模型优化不可行的高计算系统,缩放通常是必要的。

上述结果建议采用混合缩放策略,即在将模型缩放到更大的尺度之前,先在中间flop状态下优化模型,在表7的第5-6行中,我们比较了两个16GF RegNetY模型,一个由500MF模型缩放32倍,另一个由优化的4GF模型缩放4倍,采用中间模型缩放混合策略得到的模型优于0.3%。

最后,观察到最佳抽样模型的参数比比例模型少得多,我们发现,在较高的flop机制下,优化模型在最后阶段有更少的块,这大大降低了它们的参数,这表明了统一缩放模型阶段而不跨阶段重新分配块的局限性。

6.5. 大模型比较

模型缩放的主要好处是,它允许我们缩放到更大的模型,在图8中,我们使用快速缩放将四个模型缩放到16GF

我们提出以下几点看法:

1.模型排名在不同的flop机制中是一致的,缩放版本RegNetZ实现了最佳的准确性。

2. 所有通过快速缩放(dWr)获得的模型都比原始的EfficientNet模型快,包括我们的EfficientNet-B0的缩放版本。

3.最高和最低误差模型(RegNetY和RegNetZ)之间的差距从500MF时的2.2%缩小到16GF时的0.8%,这意味着在ImageNet上的模型优化可能在高flop状态下不那么重要。

4. 将中间flop模式扩展到更高的flop模式(4GF→16GF)的混合方法,填补了RegNetY和RegNetZ之间的大部分差距。

5. RegNetY是测试过的最快的模型,如果运行时受到限制,尤其是在较高的flops下,它是一个很好的选择。

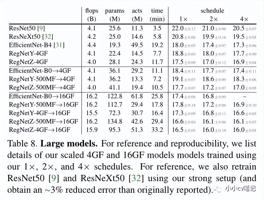

在表8中,我们给出了我们测试的4GF和16GF模型的进一步细节,以及附加的基线,我们注意到RegNetY -4GF→16GF使用的内存更少,速度比EfficientNet-B4更快,尽管这个RegNetY模型有多达4倍的flops,这强调了在比较模型时,在flops之外观察指标的重要性。

7. 讨论

在这项工作中,我们提出了一个用于分析模型伸缩策略的通用框架,该框架不仅考虑了flops,还考虑了其他网络属性,包括激活,我们展示了这些属性与现代硬件上的运行时间高度相关,根据我们的分析,我们提出了一个快速缩放策略,主要但不是唯一缩放模型宽度,快速缩放的结果是精确的模型也有快速的运行时间,虽然最佳缩放方法可能是任务相关的,但我们希望我们的工作为模型缩放推理提供一个通用框架。

以上就是关于gg修改器更改游戏数据_gg怎么修改游戏数据的全部内容,希望对大家有帮助。

gg修改器怎么更新最新版,怎么更新最新版的gg修改器? 大小:15.59MB9,389人安装 gg修改器是一款游戏内存修改神器,使用它可以轻松修改游戏中的各种数值,例如金钱、……

下载

gg修改器免root版使用,赞美GG修改器免root版让游戏更愉悦 大小:6.78MB9,314人安装 GG修改器免root版是一款非常受欢迎的游戏修改器,它可以让玩家在没有Root权限的情况……

下载

和gg修改器搭配的免root_gg修改器可用 大小:10.46MB10,639人安装 大家好,今天小编为大家分享关于和gg修改器搭配的免root_gg修改器可用的内容,赶快……

下载

gg修改器如何弄root_GG修改器如何使用 大小:7.55MB10,794人安装 大家好,今天小编为大家分享关于gg修改器如何弄root_GG修改器如何使用的内容,赶快……

下载

gg游戏修改器三国战记,GG游戏修改器三国战记:打败对手的秘密武器 大小:6.06MB9,913人安装 当你在玩三国战记游戏时,是否曾经遇到过无法击败对手的情况?或者,无论如何都无法……

下载

gg修改器中文版有吗,GG修改器中文版,助你无忧游戏 大小:14.27MB9,444人安装 随着游戏的普及,越来越多的人开始沉迷于游戏中,然而游戏中的一些难点却阻碍了玩家……

下载

gg修改器中的root权限,GG修改器:让你拥有ROOT权限的利器 大小:15.11MB9,831人安装 在使用安卓设备的过程中,你是否曾因为无法获得ROOT权限而感到困扰?这时,GG修改器……

下载

如何使gg修改器root_如何使gg修改器悬浮在游戏上方 大小:8.03MB10,790人安装 大家好,今天小编为大家分享关于如何使gg修改器root_如何使gg修改器悬浮在游戏上方……

下载

怎么开启gg修改器免root_如何设置gg修改器 大小:9.81MB10,911人安装 大家好,今天小编为大家分享关于怎么开启gg修改器免root_如何设置gg修改器的内容,……

下载

吃鸡游戏gg游戏修改器,吃鸡游戏gg游戏修改器:让你在游戏中玩得更酷炫 大小:12.87MB9,957人安装 吃鸡游戏是现在非常流行的一种游戏,是很多玩家热衷于的一种游戏方式,但是在游戏过……

下载